Ollama将DeepSeek大模型运行到本地并可视化对话

2025-03-27

首先下载ollama.exe,下载完成以后运行安装即可

https://github.com/ollama/ollama/releases/download/v0.6.2/OllamaSetup.exe

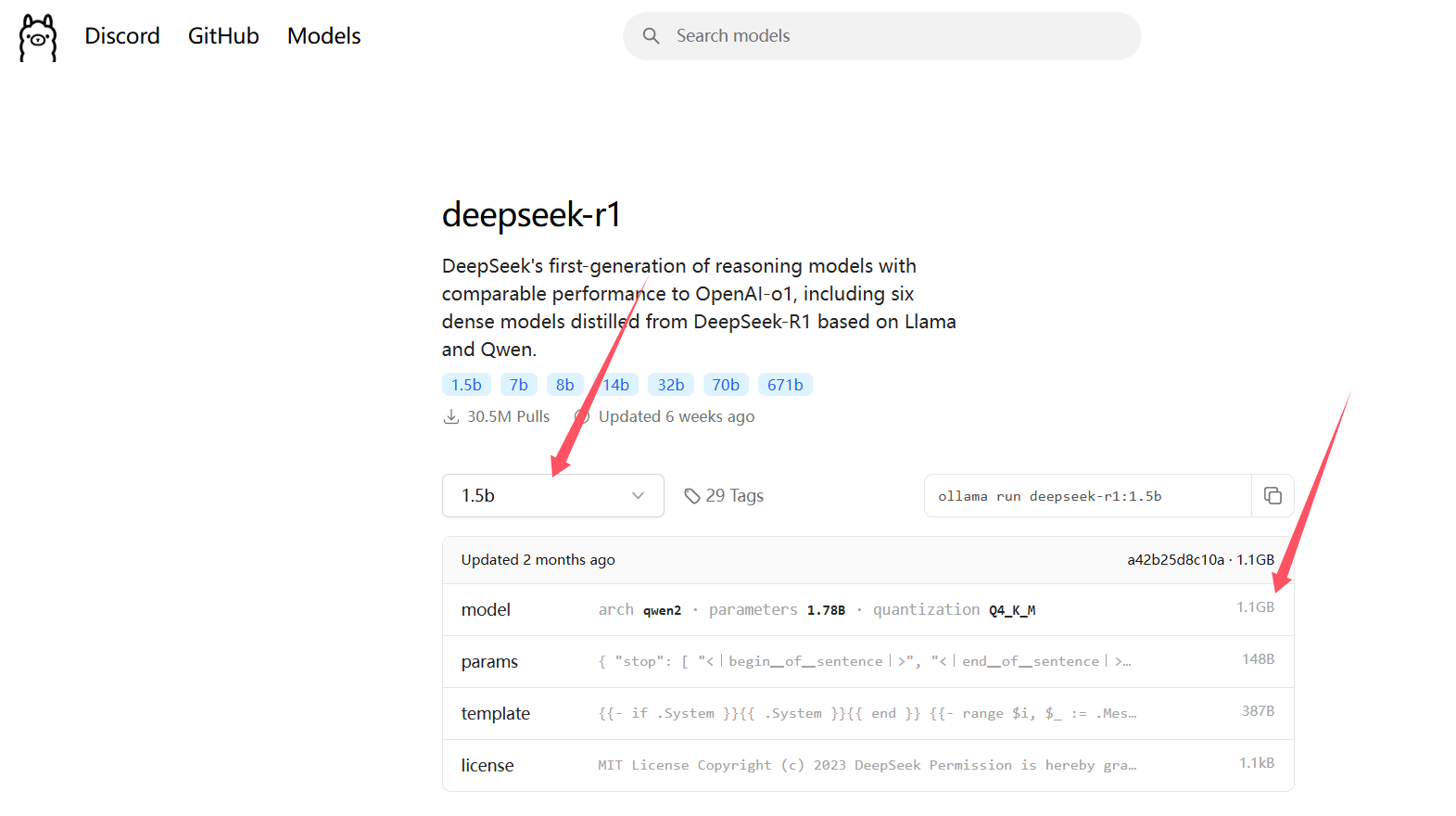

然后选择到官网自己需要的模型,这里给大家推荐deepseek,支持国产

https://ollama.com/library/deepseek-r1

上方可以更换模型规格查看一些模型信息,下方是模型文件的大小,这里科普一下,模型一般是按照训练数据来量化大小的,1.5b的意思是15亿条数据,8b是80亿

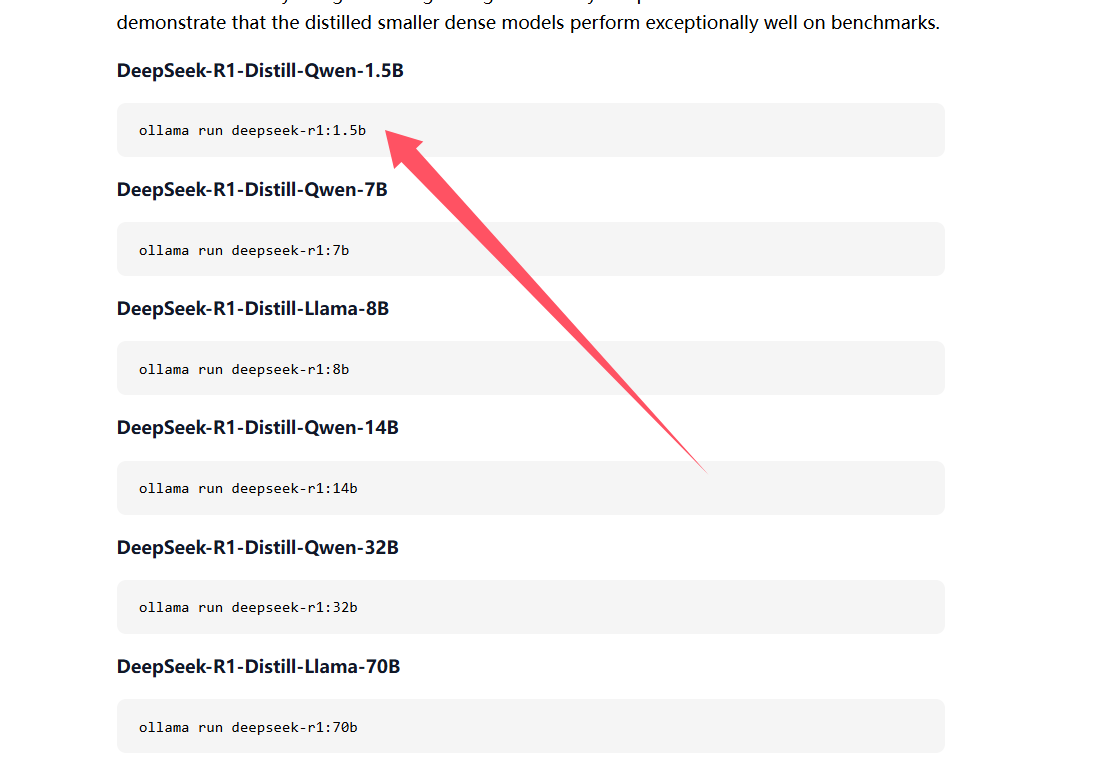

往下滑就可以看到安装命令了,复制以后回到cmd输入即可,找到对应的下载代码复制到cmd输入即可,推荐普通电脑例如3060这种垃圾显卡以及16G的低运存用1.5b就好了,其他的跑不动电脑会卡风扇起火

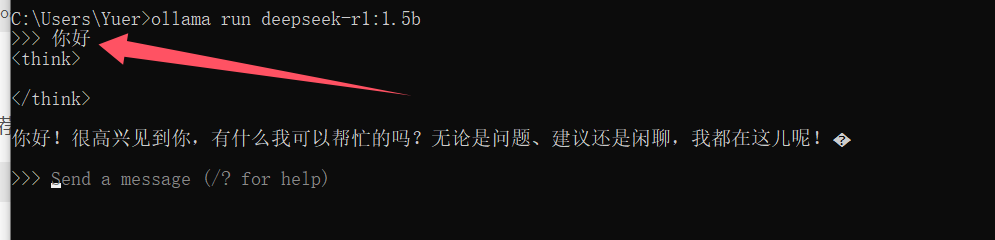

安装好以后,在这个界面就可以对话了

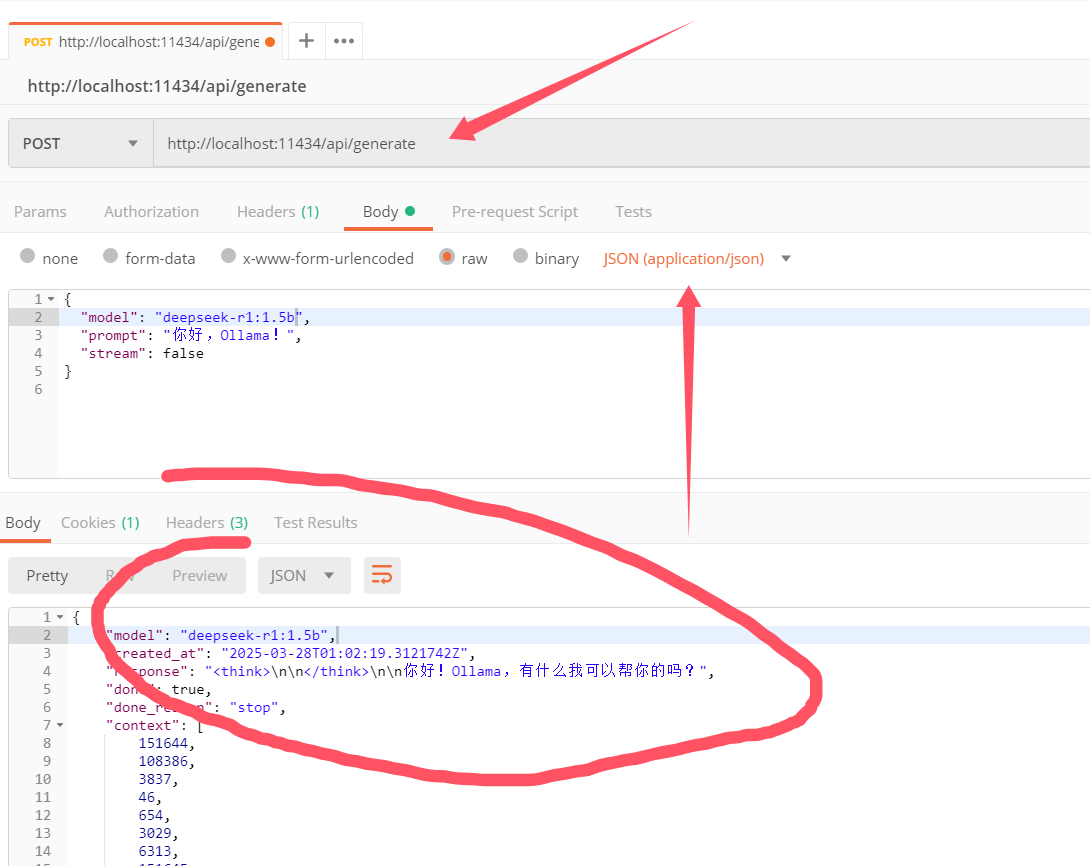

当然在这个地方对话没有任何意义,postman中调用才有意义 方法选择post,地址如下

http://localhost:11434/api/generate

"model":你要使用的模型(如"mistral"、"llama3"等)。"prompt":你要发送的指令或问题。"stream":false代表返回完整的结果,true代表流式返回(Postman 不支持流式)。

可视化步骤如下,可以通过浏览器输入如下内容检测ollama是不是挂了

localhost:11434/api/tags

如果没挂,windows电脑装一个docker desktop,然后运行如下命令就ok了

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

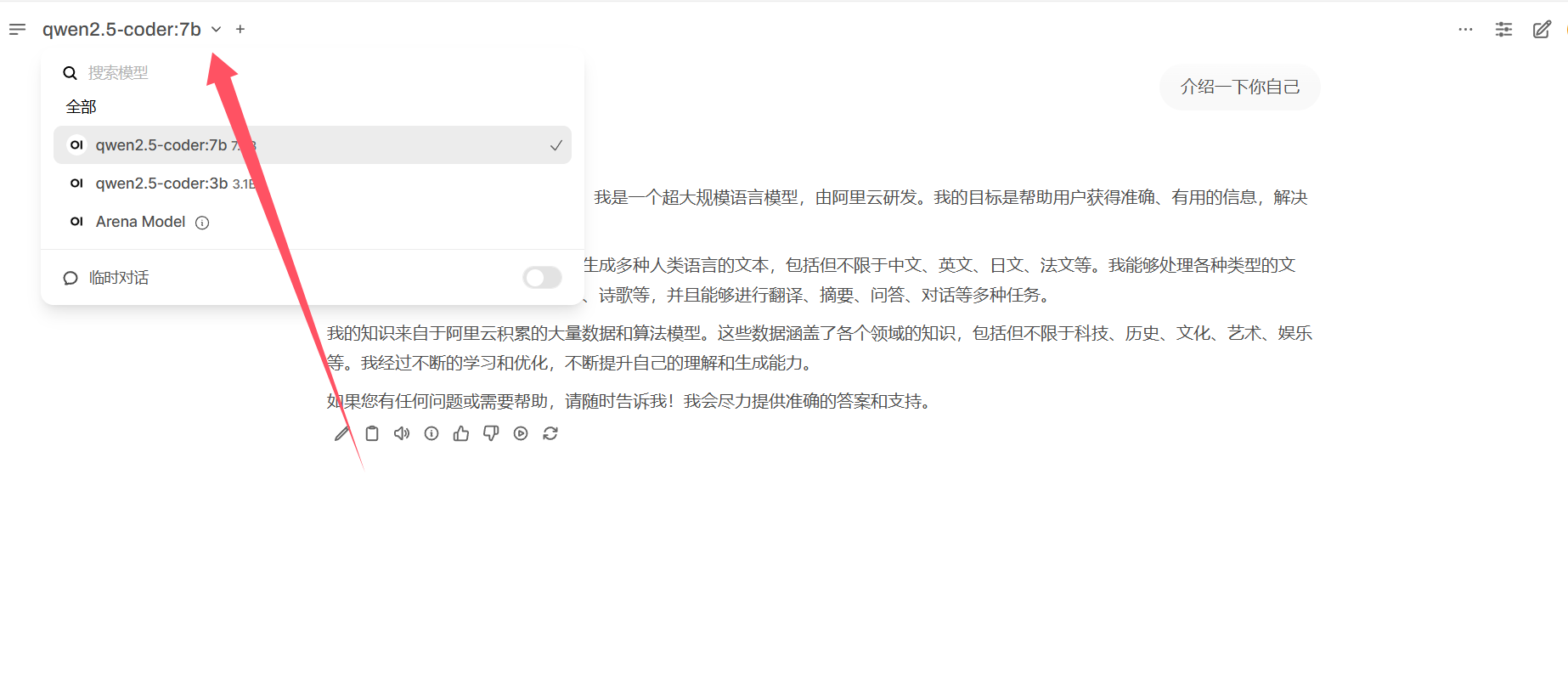

然后访问如下链接,就可以看到可视化了,左上角记得选择模型

localhost:3000

发表评论: